Perbedaan antara MapReduce dan Spark

- 3185

- 664

- Bennie Herman

Apache Spark adalah salah satu proyek sumber terbuka paling aktif di ekosistem Hadoop dan salah satu teknologi terpanas dalam analisis data besar saat ini. Baik MapReduce dan Spark adalah kerangka kerja open source untuk pemrosesan data besar. Namun, Spark dikenal untuk pemrosesan dalam memori dan sangat ideal untuk contoh di mana data cocok dalam memori, terutama pada kelompok khusus. Kami membandingkan dua kerangka kerja perangkat lunak terkemuka untuk membantu Anda memutuskan hak mana yang tepat untuk Anda.

Apa hadoop mapreduce?

MapReduce adalah model pemrograman dalam kerangka Hadoop untuk komputasi terdistribusi berdasarkan java. Ini digunakan untuk mengakses data besar di Sistem File Hadoop (HDFS). Ini adalah cara untuk menyusun perhitungan Anda yang memungkinkannya dengan mudah dijalankan pada banyak mesin. Ini memungkinkan skalabilitas besar -besaran di ratusan atau ribuan server di kluster hadoop. Ini memungkinkan menulis pekerjaan terdistribusi dan dapat diskalakan dengan sedikit usaha. Ini melayani dua fungsi penting: Ini menyaring dan mendistribusikan pekerjaan ke berbagai node di dalam cluster atau peta. Ini digunakan untuk analisis data skala besar menggunakan beberapa mesin di cluster. Kerangka kerja MapReduce biasanya merupakan proses tiga langkah: peta, kocok dan kurangi.

Apa itu Apache Spark?

Spark adalah open source, kerangka kerja data besar yang sangat cepat dianggap sebagai penerus kerangka kerja MapReduce untuk memproses data besar. Spark adalah Hadoop Enhancement to MapReduce yang digunakan untuk beban kerja data besar. Untuk organisasi yang memiliki data dalam jumlah besar untuk dianalisis, Spark menawarkan cara yang cepat dan mudah untuk menganalisis data itu di seluruh kelompok komputer. Ini adalah mesin analitik terpadu multi-bahasa untuk data besar dan pembelajaran mesin. Model pemrograman terpadu menjadikannya pilihan terbaik untuk pengembang yang membangun aplikasi analitik yang kaya data. Ini dimulai pada tahun 2009 sebagai proyek penelitian di UC Berkley's AMPLAB, upaya kolaboratif yang melibatkan siswa, peneliti, dan fakultas.

Perbedaan antara MapReduce dan Spark

Pengolahan data

- Hadoop memproses data dalam batch dan mapReduce beroperasi dalam langkah berurutan dengan membaca data dari cluster dan melakukan operasinya pada data. Hasilnya kemudian ditulis kembali ke cluster. Ini adalah cara yang efektif untuk memproses kumpulan data yang besar dan statis. Spark, di sisi lain, adalah mesin pemrosesan data terdistribusi tujuan umum yang memproses data secara paralel di seluruh cluster. Itu melakukan pemrosesan data waktu nyata dan grafik.

Pertunjukan

- Hadoop MapReduce relatif lebih lambat karena melakukan operasi pada disk dan tidak dapat memberikan analitik waktu nyata dari data. Spark, di sisi lain, dirancang sedemikian rupa sehingga mengubah data dalam memori dan bukan dalam disk I/O, yang pada gilirannya mengurangi waktu pemrosesan. Spark sebenarnya 100 kali lebih cepat dalam memori dan 10 kali lebih cepat pada disk. Tidak seperti MapReduce, itu bisa menangani pemrosesan waktu nyata.

Biaya

- Hadoop berjalan dengan biaya lebih rendah karena ini adalah perangkat lunak open-source dan membutuhkan lebih banyak memori pada disk yang relatif merupakan komoditas yang murah. Spark membutuhkan lebih banyak RAM yang berarti mengatur cluster percikan bisa lebih mahal. Selain itu, Spark relatif baru, jadi para ahli di Spark adalah temuan langka dan lebih mahal.

Toleransi kesalahan

- Mapreduce berbasis disk berarti menggunakan penyimpanan persisten. Sementara keduanya memberikan beberapa tingkat kegagalan penanganan, toleransi kesalahan Spark didasarkan terutama pada operasi RDD (Dataset Terdistribusi Tangguh). RDD adalah blok bangunan Apache Spark. Hadoop secara alami toleran terhadap kesalahan karena dirancang untuk mereplikasi data di beberapa node.

Kemudahan penggunaan

- MapReduce tidak memiliki mode interaktif dan cukup kompleks. Perlu menangani API tingkat rendah untuk memproses data, yang membutuhkan banyak pengkodean, dan pengkodean membutuhkan pengetahuan tentang struktur data yang terlibat. Spark direkayasa dari bawah ke atas untuk kinerja dan kemudahan penggunaan, yang berasal dari model pemrograman umumnya. Juga, program paralel sangat mirip dengan program berurutan, membuatnya lebih mudah untuk dikembangkan.

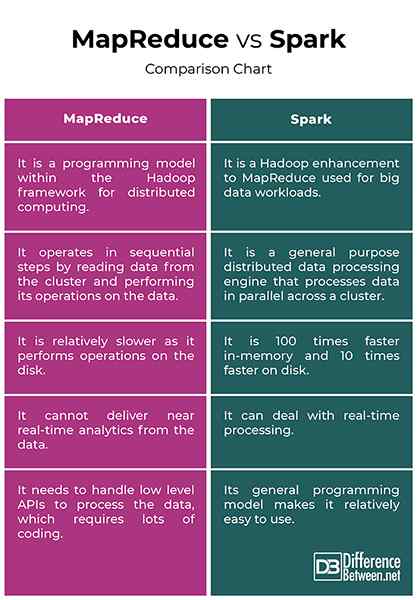

MapReduce vs. Spark: Bagan Perbandingan

Ringkasan

Perbedaan utama antara dua kerangka kerja adalah bahwa MapReduce memproses data pada disk sedangkan percikan proses dan menyimpan data dalam memori untuk langkah -langkah selanjutnya. Akibatnya, percikan 100 kali lebih cepat dalam memori dan 10 kali lebih cepat pada disk daripada MapReduce. Hadoop menggunakan MapReduce untuk memproses data, sementara Spark menggunakan Dataset Terdistribusi Tangguh (RDD). Spark adalah peningkatan mapreduce hadoop untuk memproses data besar. Sementara MapReduce masih digunakan untuk analisis data skala besar, Spark telah menjadi kerangka kerja pemrosesan di lingkungan Hadoop.

Mengapa Spark lebih cepat dari MapReduce?

Spark Proses dan menyimpan data dalam memori untuk langkah -langkah selanjutnya, yang membuatnya 100 kali lebih cepat untuk data dalam RAM dan hingga 10 kali lebih cepat untuk data dalam penyimpanan. RDD -nya memungkinkan beberapa operasi peta dalam memori, sedangkan MapReduce harus menulis hasil sementara ke disk.

Apa perbedaan antara name Spark dan MapReduce setidaknya dua poin?

Pertama, MapReduce tidak dapat memberikan analitik waktu nyata dari data, sementara Spark dapat menangani pemrosesan data waktu nyata. Dan kedua, MapReduce beroperasi dalam langkah berurutan sedangkan Spark memproses data secara paralel di seluruh cluster.

Adalah percikan lebih maju dari mapreduce?

Spark secara luas dianggap sebagai penerus kerangka kerja MapReduce untuk memproses Big Data. Faktanya, Spark adalah salah satu proyek sumber terbuka paling aktif di ekosistem Hadoop dan salah satu teknologi terpanas dalam analisis data besar saat ini.

Apakah Spark membutuhkan MapReduce?

Spark tidak menggunakan atau membutuhkan MapReduce, tetapi hanya gagasannya dan bukan implementasi yang tepat.

- « Perbedaan antara bias pembelajaran mesin dan varian

- Perbedaan antara masthead dan rig fraksional »